La hazaña informática es una revolución para entender y describir el loco mundo de lo pequeño. Como explican desde el Flatiron Institute, contribuiría a resolver uno de los problemas más difíciles de la física cuántica

Un algoritmo de inteligencia artificial desarrollado por un equipo internacional de científicos de 8 universidades y centros de investigación alrededor del globo ha conseguido reducir el número de ecuaciones involucradas en un problema de física cuántica de 100 000 a tan solo cuatro, y sin perder precisión. Este resultado es un paso de gigante considerable en el estudio de sistemas de muchos cuerpos como, por ejemplo, un sistema con muchos electrones, y ha sido publicado recientemente en la revista Physical Review Letters.

Con este trabajo, han conseguido capturar el movimiento de los electrones que se desplazan por una red cuadrada en simulaciones que, hasta ahora, habían requerido cientos de miles de ecuaciones individuales. Si la técnica es adaptable a otras situaciones, ayudaría a la generación de materiales con características deseables, como la superconductividad o útiles para la generación de energía limpia.

La hazaña informática es una revolución para entender y describir el loco mundo de lo pequeño. Como explican desde el Flatiron Institute, contribuiría a resolver uno de los problemas más difíciles de la física cuántica, el problema de los “n” cuerpos, que trata de describir sistemas que contienen, por ejemplo, un gran número de electrones que interactúan entre sí.

Pero, ¿qué significa? ¿Por qué es tan relevante lo conseguido? Empecemos por el principio:

El siglo XX trajo consigo una nueva física

La física cuántica en la rama de la física que se ocupa de lo más pequeño, de cómo funciona, de cómo interacciona, etc. Surgió a finales del siglo XIX de la mano de de Max Planck.

Planck demostró que la física existente hasta aquel día no era suficiente para explicar la emisión de energía por parte de un objeto caliente. Resultó que todo cuadraba cuando la energía emitida por el cuerpo era un numero entero de veces cierta constante, que además no tenía símil clásico. Planck se mantuvo receloso de su hallazgo hasta que la evidencia se hizo patente, ya que los datos experimentales de otros científicos encajaban a la perfección con su teoría.

Dos pasos de gigante para la aceptación de la teoría propuesta por Planck los dieron, por este orden, Albert Einstein y Niels Bohr.

Einstein utilizó la teoría cuántica para demostrar el efecto fotoeléctrico, descrito unas décadas antes por Heinrich Hertz.

Por otro lado, Niels Bohr propuso un modelo de átomo en el cual los electrones sólo podían ocupar órbitas cuyo momento angular fuera un numero entero de veces la constante reducida de Planck. Ambos fueron galardonados, en 1905 y 1922, respectivamente, con el premio Nobel de Física.

Problemas complejos de difícil solución

Resolver de forma exacta problemas físicos que involucren más de dos cuerpos no es tarea sencilla. Un ejemplo clásico de ello es el famoso Problema de los tres cuerpos, que consiste en hallar, para cualquier instante de tiempo, las trayectorias de tres cuerpos con masa sujetos a atracción gravitatoria, dadas sus condiciones iniciales de posición y velocidad. Un problema que a priori puede parecer sencillo, ya que son solo tres cuerpos y la interacción gravitatoria se conoce a la perfección, no lo es. De hecho, se trata de un sistema caótico, es decir, con una pequeñísima variación de las condiciones iniciales, el sistema evoluciona de forma totalmente distinta.

Podemos suponer que si el problema de los tres cuerpos no tiene solución analítica, mucho menos la tendrá un problema que involucre un número mayor de cuerpos, digamos n. A esto se le denomina el Problema de los n cuerpos.

La mayoría del trabajo realizado en esta línea se ha centrado en la interacción gravitatoria pero otros problemas de índole distinta también pueden ser clasificados como problemas de n cuerpos. Por ejemplo, la simulación de moléculas grandes como proteínas o la dinámica e interacción de grupos de partículas elementales como electrones.

El Grupo de renormalización

Analizar la dinámica de un grupo de electrones dadas sus condiciones iniciales es un problema extremadamente complejo cuya solución numérica no es fácil de obtener. Este problema involucra varias magnitudes tales como el espín, la carga, etc. Una manera de resolverlo es usando el llamado Grupo de renormalización.

Existen dos variantes. La primera consiste en agarrar bloques de varias partículas y considerarlos como una partícula “gorda”. Este proceso se puede iterar varias veces reduciendo la dimensionalidad del problema. La segunda variante consiste en reducir la resolución espacial del problema, sacrificándola para obtener un resultado aceptable.

En todo caso, hay problemas en física en los cuales es complicado encontrar soluciones numéricas incluso usando el Grupo de renormalización, ya que el número de ecuaciones involucradas es enorme y la potencia de cálculo necesaria para resolverlas inabordable. Quizá con computación cuántica sería factible pero por el momento no lo es.

La inteligencia artificial al rescate

Y aquí es cuando llegamos a la relevancia de reducir un problema de física cuántica de miles de ecuaciones a solo cuatro.

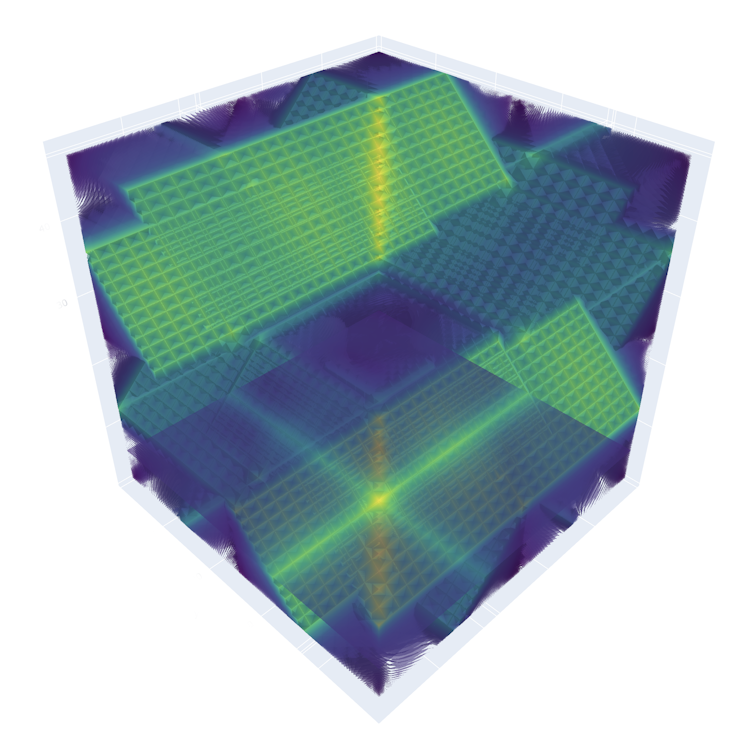

Recientemente, un grupo de investigadores de Europa y Estados Unidos ha usado un algoritmo de inteligencia artificial para reducir el número de ecuaciones involucradas en el análisis cuántico de un modelo de Hubard en dos dimensiones de 100 000 a tan solo cuatro, y todo ello sin perder precisión.

El modelo de Hubard es el modelo físico más sencillo que describe la interacción entre partículas de una red, entendida como una distribución quasi-regular de partículas en una, dos o tres dimensiones, con solo dos términos en el hamiltoniano (energéticos), uno cinético asociado a la velocidad y otro potencial asociado a la vecindad de otras partículas.

En el caso de un Modelo de Hubard bidimensional, el número de variables es aparentemente enorme, ya que se deberían tener en cuenta los acoplamientos entre cada pareja de partículas.

Por el contrario, tal y como los autores de la publicación demuestran, la dimensionalidad del problema se puede reducir sin perder precisión usando algoritmos de inteligencia artificial y machine learning. Para ello han usado una red neuronal llamada Neural Ordinary Differential Equations.

Los pormenores del proceso que llevaron a cabo pueden consultarse en la publicación original, pero quedémonos con que la inteligencia artificial y el machine learning serán probablemente piezas fundamentales en muchos de los descubrimientos científicos y tecnológicos que nos depara el futuro, así que más nos vale estar preparados.![]()

Francisco José Torcal Milla, Profesor Titular. Departamento de Física Aplicada. Centro: EINA. Instituto: I3A, Universidad de Zaragoza

Este artículo fue publicado originalmente en The Conversation. Lea el original.

Te recomendamos

Te recomendamos METADATA, el podcast de tecnología de RPP. Noticias, análisis, reseñas, recomendaciones y todo lo que debes saber sobre el mundo tecnológico.

Comparte esta noticia

Siguenos en